El 30 de enero de 2023, el creador de contenido Atrioc mostró durante una transmisión en Twitch (sin darse cuenta) contenidos de una web pornográfica, en la que aparecían deepfakes (vídeos manipulados con inteligencia artificial para suplantar la identidad de una persona) que empleaban, sin su consentimiento, la imagen de otras creadoras de contenido como Pokimane, Maya Higa y QTCinderella. Estos vídeos de contenido sexual han reabierto el debate sobre el uso ético de estas tecnologías, así como las consecuencias que tienen para las víctimas, porque no se trata de un caso aislado.

Varias creadoras de contenido han denunciado el uso de ‘deepfakes’ sexuales no consentidos

Después del despiste de Atrioc durante un programa, donde mostró que había estado consumiendo contenido pornográfico que empleaba la imagen generada con deepfakes de otras streamers, sin el consentimiento de estas, la noticia explotó. Cuando en las redes sociales se reparó en lo sucedido, el streamer realizó una transmisión en directo disculpándose por su actitud con las víctimas de estos contenidos, y publicó un comunicado en el que anunciaba su retirada de Twitch.

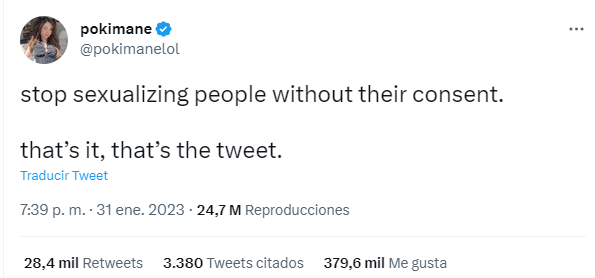

El contenido consumido utilizaba la tecnología deepfake que, como hemos explicado en Maldita.es, son vídeos manipulados con inteligencia artificial para crear imágenes falsas que parezcan reales. En este caso, se ha utilizado para crear contenido pornográfico. Entre las víctimas de este tipo de material no consensuado se encuentra la creadora de contenido Pokimane, que ha pedido en su Twitter que se deje de “sexualizar a las personas sin su consentimiento”.

“Parad de sexualizar a las personas sin su consentimiento. Eso es, ese es el tuit”

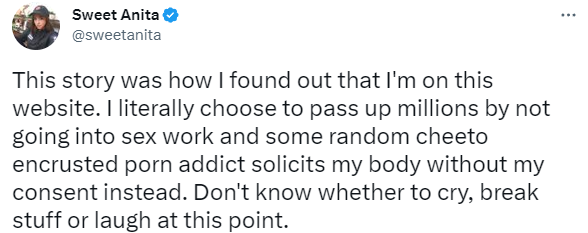

“Parad de sexualizar a las personas sin su consentimiento. Eso es, ese es el tuit”La streamer Sweet Anita, cuyos deepfakes también aparecen en este tipo de contenido pornográfico, ha asegurado en redes sociales que se ha enterado de la existencia de estos contenidos a raíz de este suceso, y ha criticado el uso de su imagen sin su consentimiento.

“Con esta historia fue con la que me enteré de que estoy en ese sitio web. Literalmente elegí no ganar millones al no dedicarme al trabajo sexual y, en lugar de esto, un adicto cualquiera al porno sucio solicita mi cuerpo sin mi consentimiento. No sé si llorar, romper cosas o reír en este momento”.

“Con esta historia fue con la que me enteré de que estoy en ese sitio web. Literalmente elegí no ganar millones al no dedicarme al trabajo sexual y, en lugar de esto, un adicto cualquiera al porno sucio solicita mi cuerpo sin mi consentimiento. No sé si llorar, romper cosas o reír en este momento”.Otra de las víctimas, QTCinderella, realizó una transmisión el 31 de enero detallando que había recibido comentarios privados en los que otros usuarios le habían enviado aquellas imágenes, y en la que aseguró muy afectada y cabreada que iba a denunciar a la plataforma que había publicado este vídeo: “Y a la persona que ha hecho esa página, te voy a denunciar. Te lo prometo, con cada parte de mi alma”.

El uso de ‘deepfakes’ sin consentimiento en contenidos pornográficos es una práctica extendida

El empleo de la técnica de deepfakes en contenidos pornográficos no es una práctica nueva, ni residual. Un estudio publicado en 2019 por Deeptrace Labs, compañía especializada en inteligencia artificial, señaló que alrededor del 96% de los vídeos analizados por la empresa que emplearon esta tecnología estaban basados en imágenes de mujeres, en su mayoría famosas, y se habían utilizado para contenidos sexuales sin su consentimiento, según recoge Vox Media. La revista MIT Technology Review también ha alertado de la proliferación de aplicaciones destinadas a estos fines.

En el programa la Twichería de Maldita Tecnología sobre deepfakes, Liliana Arroyo, doctora en Sociología e investigadora del Instituto de Innovación Social de ESADE, nos explicó cómo esta tecnología nació "con una finalidad pornográfica" y que “hay portales enteros dedicados al deepfake" alrededor de contenidos sexuales.

“Los deepfakes nacen en 2017 con intención de usarlos en un formato pornográfico. Cogieron la cara de una celebridad y la pusieron en una escena pornográfica, y ahí es cuando se empezó a difundir”, detalla la experta, que incidió en que “todas estas innovaciones tienen que estar acompañadas de un debate social para que podamos establecer cuáles son los usos que creamos que sean adecuados y cuáles no”.

De momento no hay un marco normativo sobre estas prácticas, pero preocupa en Europa

La cuestión de los deepfakes con contenidos sexuales también ha preocupado a los gobiernos de algunos países. Reino Unido anunció el 25 de noviembre de 2022 que emprenderá nuevas medidas para proteger a las víctimas de este tipo de imágenes, incluyendo el “criminalizar el intercambio no consentido de imágenes íntimas fabricadas”.

La Unión Europea también ha prestado atención al uso de esta herramienta, y la Comisión Europea ha planteado, dentro de su propuesta de Ley de Inteligencia Artificial, que los vídeos generados a través de deepfake cumplan una serie de obligaciones en materia de transparencia cuando esta tecnología esté involucrada.

1 year ago

71

1 year ago

71